Gemma是谷歌发布的轻量级开源模型,其性能强大可与主流开源模型竞争。通过Ollama我们可以轻松的在本地部署Gemma模型。根据Google介绍,开源模型Gemma使用了和Gemini同源的技术,总共有20亿参数和70亿参数两种规模,每个规模又分预训练和指令微调两个版本。在Gemma官方页面上,Google给出了Gemma在语言理解、推理、数学等各项标准测试中的得分,其中70亿参数模型击败了主流开源模型Llama-2和Mistral,直接登顶Hugging Face开源大模型排行榜,成为目前全球最火热的开源大模型之一。

其中最基础的2b模型即便是在没有独显的笔记本电脑上都能尝试运行,而规模更大的7b、7b全量版分别需要8GB和16GB显存。(最重要的是没网也可以本地运行)

1、安装Ollama

Ollama 是一个专为运行、创建和分享大型语言模型而设计的开源项目,为开发者和研究者提供了一个平台,使得他们可以更方便地部署、管理和使用这些大型语言模型。目前Ollama支持支持 macOS、Windows、Linux 和 Docker等多种安装方式,还能通过 API 方式为本地 AI 服务提供便捷途径。

进入官网选择你的操作系统:https://ollama.com/download(这里MacOS举例)

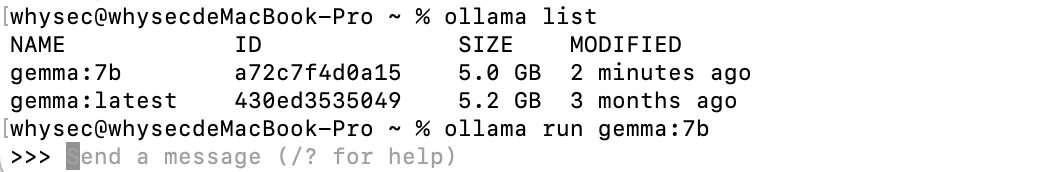

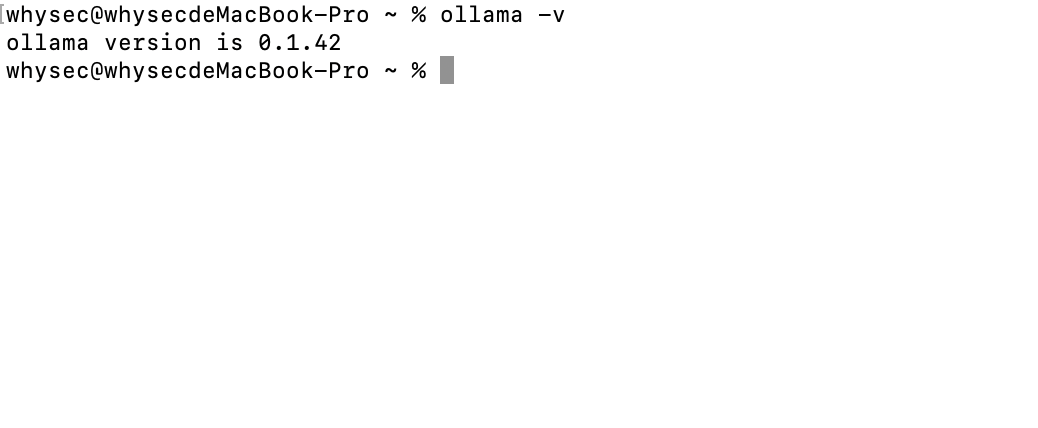

输入命令查看是否安装正确:ollama -v

2、拉取并运行Gemma模型

Gemma分为2b模型和7b模型,根据你自己的电脑配置以及需要安装。这里我们就以Gemma 2b的基础模型为例子。

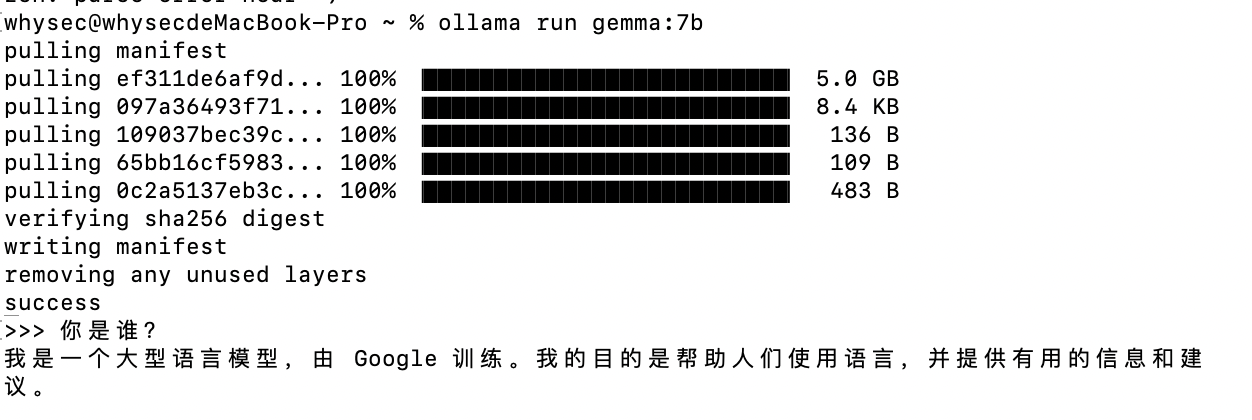

输入命令:ollama run gemma:2b (7b版本 ollama run gemma:7b)

安装完成后会自动运行该模型。

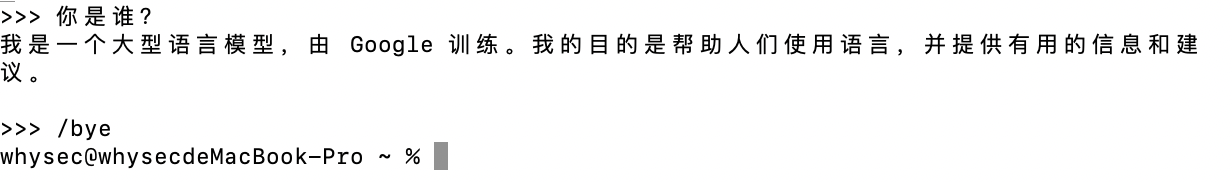

到这里我们的gemma模型已经安装成功啦,是不是非常简单。

如果你想要退出的话可以输入 /bye

如果你还想安装其他模型可以去ollama官网查看列表:https://ollama.com/library

重新启动Gemma模型

当你退出后想重新启动使用我们可以输入命令:ollama run gemma:7b(你要运行的模型名字)